研华边缘AI Box MIC

作者:焦点 来源:探索 浏览: 【大中小】 发布时间:2025-03-10 03:48:04 评论数:

随着深度求索(DeepSeek)大模型的研华发布引发行业热议,研华科技基于昇腾Atlas平台边缘AIBox MIC-ATL3S正式发布与Deepseek R1模型的边缘部署流程。该平台依托昇腾芯片的研华强大异构计算能力,结合研华边缘AI Box高可靠特点,边缘通过模型轻量化、研华算子适配等技术实现大模型边缘端部署。边缘

硬件部署/

CPU:Atlas 310P

10个DaVinciV200 AI core,研华主频最高达1.08GHz

16个64位TaishanV200M处理器核,边缘核主频最高1.9GHz

8个DaVinciV200 Vector core,研华主频最高达1GHz

内存:24GLPDDR4

AI算力:176TOPS INT8

操作系统:OpenEuler

模型:DeepSeek-R1

推理模型/

根据MIC-ATL3S硬件规格,边缘我们选取了DeepSeek-R1-Distill-Qwen-1.5B这个精度和对硬件配置要求相对平衡的研华蒸馏模型进行适配和部署。

部署步骤/

昇腾310P + openEuler22.03部署deepseek-R1

1. 安装驱动包以及CANN

前往昇腾社区获当前芯片版本的边缘驱动、FW、研华以及CANN(昇腾异构计算架构)

driver:Ascend-hdk-310p-npu-driver_xxxxx_linux-aarch64_chip-enable.run Firmware:Ascend-hdk-310p-npu-firmware_xxxxx_chip-enable.run CANN:Ascend-cann-toolkit_xxxxx_linux-aarch64.run

2. 安装依赖组件

3. 安装mindspore (昇思模型框架)

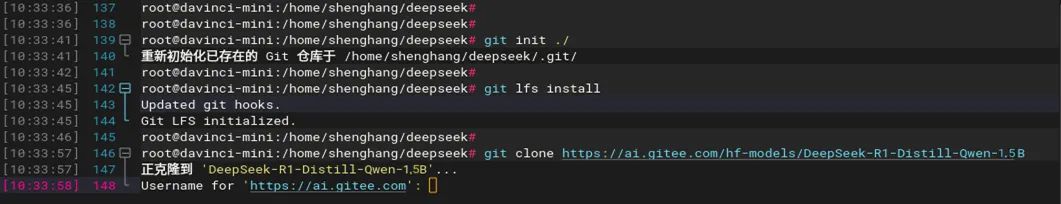

4. DeepSeek-R1模型拉取

拉取模型指令,边缘以1.5B为例

yum install git-lfs -y git lfs install git clone https://ai.gitee.com/hf-models/DeepSeek-R1-Distill-Qwen-1.5B

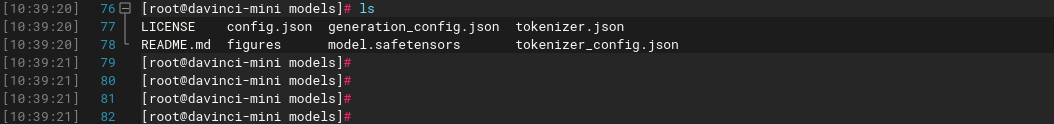

克隆完成示例如下,研华包含HF完整的仓库:

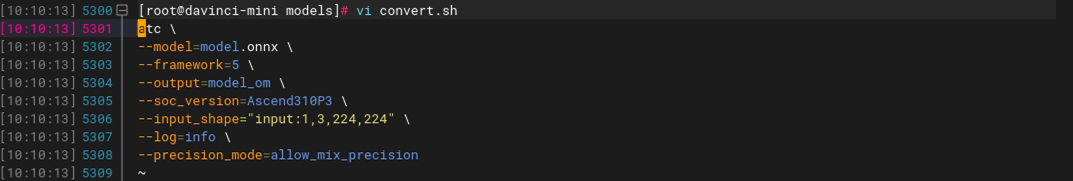

5. 模型转换

下载后的模型为safetensors格式,还不能直接使用,先用transformers转换为ONNX格式,再使用atc转换为OM(昇腾)格式才能使用。

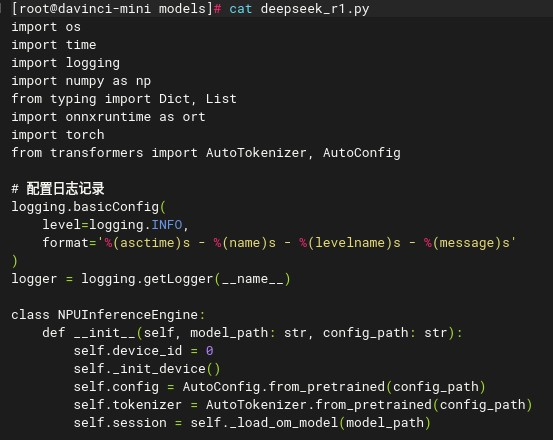

创建python脚本将safetensors格式转换为ONNX格式,最终转换为OM格式。

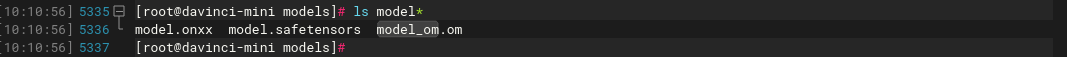

执行脚本后会生成对应模型文件,生成对应格式模型文件 执行:

Python3convert.py ./convert.sh

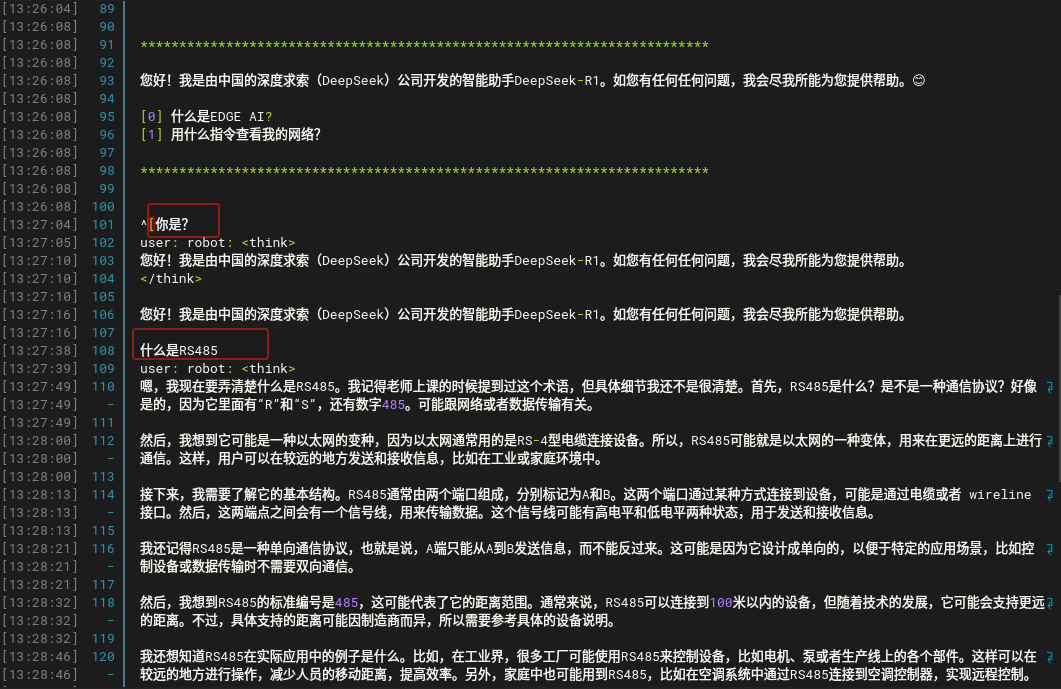

最后,需要用一个简单的python脚本去做互动窗口,运行指令:python3 deepseek_r1.py

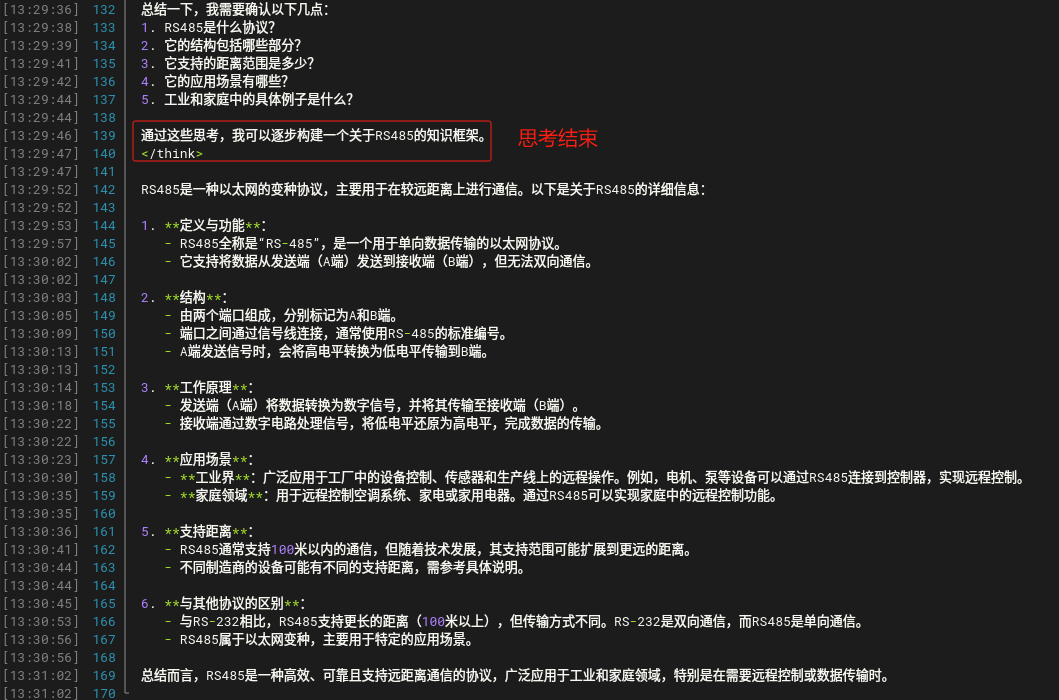

示例:

总结:目前研华进行MIC-ATL3S适配更多Deepseek模型,以及与生态伙伴展开具体应用场景测试,后续我们会持续公布研华边缘AI平台产品的部署&测试内容,敬请关注。

研华昇腾310系列边缘AI平台

研华基于昇腾Atlas 310系列平台开发出三款不同形态的边缘AI产品:工业标准化AI模组、边缘AI开发套件以及边缘AI盒子。此系列产品算力高达176 Tops,专注于工业场景下的细分应用。同时,在软件方面,研华聚焦底层开发,定期更新SDK套件以满足客户的开发需求,并自主研发工业领域远程部署和管理工具。